Kljub uspehu nadzorovanega strojnega učenja in globokega učenja obstaja miselna šola, ki pravi, da ima nenadzorovano učenje še večji potencial. Učenje nadzorovanega učnega sistema je omejeno z njegovim usposabljanjem; tj. Nadzorovani učni sistem se lahko nauči samo tistih nalog, za katere je usposobljen. Nasprotno pa bi lahko nenadzorovani sistem teoretično dosegel "umetno splošno inteligenco", kar pomeni sposobnost učenja katere koli naloge, ki se je človek lahko nauči. Vendar tehnologije še ni.

Če je največja težava nadzorovanega učenja strošek označevanja podatkov o usposabljanju, je največja težava nenadzorovanega učenja (kjer podatki niso označeni) ta, da pogosto ne deluje zelo dobro. Kljub temu se nenadzorovano učenje resnično uporablja: včasih je dobro za zmanjšanje dimenzij nabora podatkov, raziskovanje vzorca in strukture podatkov, iskanje skupin podobnih predmetov ter odkrivanje odstopanj in drugih hrupov v podatkih.

Na splošno velja preizkusiti nenadzorovane učne metode kot del raziskovalne analize podatkov, da bi odkrili vzorce in grozde, zmanjšali dimenzionalnost podatkov, odkrili latentne lastnosti in odstranili izstopajoče elemente. Ali boste potem morali nadaljevati z nadzorovanim učenjem ali z uporabo predhodno usposobljenih modelov za napovedovanje, je odvisno od vaših ciljev in vaših podatkov.

Kaj je nenadzorovano učenje?

Pomislite, kako se učijo človeški otroci. Kot staršu ali učitelju vam ni treba pokazati majhnim otrokom vseh vrst psov in mačk, da bi jih naučili prepoznati pse in mačke. Učijo se lahko na nekaj primerih, brez veliko razlag, in posplošujejo sami. Oh, morda čivavo najprej zmotno pokličejo "Kitty", ko jo prvič vidijo, vendar lahko to razmeroma hitro popravite.

Otroci intuitivno združujejo skupine stvari, ki jih vidijo, v razrede. Eden od ciljev nenadzorovanega učenja je v bistvu omogočiti računalnikom, da razvijejo enake sposobnosti. Kot sta v svojem zapisu na blogu zapisala Alex Graves in Kelly Clancy iz DeepMind, "Nenadzorovano učenje: radovedni učenec,"

Nenadzorovano učenje je paradigma, zasnovana za ustvarjanje avtonomne inteligence z nagrajevanjem agentov (to je računalniških programov) za učenje o podatkih, ki jih opazujejo brez posebne naloge v mislih. Z drugimi besedami, agent se uči zaradi učenja.

Potencial agenta, ki se uči zaradi učenja, je veliko večji od sistema, ki zapletene slike zmanjša na binarno odločitev (npr. Pes ali mačka). Odkrivanje vzorcev namesto izvajanja vnaprej določene naloge lahko prinese presenetljive in koristne rezultate, kar se je pokazalo, ko so raziskovalci v laboratoriju Lawrence Berkeley Lab uporabili algoritem za obdelavo besedila (Word2vec) na več milijonih povzetkih znanosti o materialih, da bi napovedali odkritja novih termoelektričnih materialov.

Metode grozdenja

Problem grozdenja je nenadzorovan učni problem, ki od modela zahteva iskanje skupin podobnih podatkovnih točk. Trenutno se uporabljajo številni algoritmi za združevanje v skupine, ki imajo ponavadi nekoliko drugačne značilnosti. Na splošno algoritmi za združevanje v skupine preučijo meritve ali funkcije razdalje med vektorji značilnosti podatkovnih točk in nato razvrstijo tiste, ki so si "blizu". Algoritmi grozdanja delujejo najbolje, če se razredi ne prekrivajo.

Hierarhično združevanje

Hierarhična analiza grozdov (HCA) je lahko aglomerativna (grozde zgradite od spodaj navzgor, začenši s posameznimi točkami in konča z eno skupino) ali razdelilna (začnete z eno grozdom in jo razbijete, dokler ne končate s posameznimi točkami). Če imate srečo, lahko najdete vmesno stopnjo postopka združevanja v skupine, ki odraža smiselno razvrstitev.

Proces združevanja je ponavadi prikazan kot dendrogram (drevesni diagram). Algoritmi HCA ponavadi zahtevajo veliko računalniškega časa [O(n3)] in pomnilnik [O(n2)] virov; ti omejujejo uporabnost algoritmov na razmeroma majhne nabore podatkov.

Algoritmi HCA lahko uporabljajo različne meritve in merila povezave. Evklidska razdalja in kvadrat na evklidsko razdaljo sta običajni za numerične podatke; Hammingova razdalja in Levenshteinova razdalja sta skupni za numerične podatke. Pogosta sta enojna povezava in popolna povezava; oba lahko poenostavita algoritme grozdenja (SLINK oziroma CLINK). SLINK je eden redkih algoritmov za združevanje v skupine, za katerega je zagotovljeno, da bo našel optimalno rešitev.

K-pomeni združevanje v skupine

Problem grozdanja k-pomeni, da se poskuša deliti n opazovanja v k grozdi z uporabo evklidske metrike razdalje, da bi zmanjšali varianco (vsoto kvadratov) znotraj vsake gruče. Je metoda vektorske kvantizacije in je uporabna za učenje lastnosti.

Lloydov algoritem (iterativno združevanje grozdov s posodobitvami centroidov) je najpogostejša hevristika, ki se uporablja za reševanje problema, in je razmeroma učinkovit, vendar ne zagotavlja globalne konvergence. Da bi to izboljšali, ljudje pogosto večkrat zaženejo algoritem z uporabo naključnih začetnih centroidov grozdov, ustvarjenih z metodama Forgy ali Random Partition.

K-pomeni predpostavlja sferične gruče, ki jih je mogoče ločiti, tako da se srednja vrednost konvergira proti središču gruče, in tudi, da urejanje podatkovnih točk ni pomembno. Grozdi naj bi bili podobne velikosti, tako da je dodelitev najbližjemu središču grozda pravilna dodelitev.

Hevristika za reševanje skupin k-pomeni je običajno podobna algoritmu maksimizacije pričakovanj (EM) za Gaussove modele mešanic.

Modeli mešanic

Modeli mešanic predpostavljajo, da podpopulacije opazovanj ustrezajo določeni verjetnostni porazdelitvi, običajno Gaussovi porazdelitvi za numerična opazovanja ali kategorični porazdelitvi za nenumerične podatke. Vsaka podskupina ima lahko svoje lastne parametre porazdelitve, na primer povprečje in varianco Gaussovih porazdelitev.

Maksimizacija pričakovanj (EM) je ena izmed najbolj priljubljenih tehnik, ki se uporablja za določanje parametrov mešanice z danim številom komponent. Poleg EM lahko modele zmesi rešujemo z Markovo verigo Monte Carlo, ujemanjem trenutkov, spektralnimi metodami z razgradnjo singularne vrednosti (SVD) in grafičnimi metodami.

Prvotna aplikacija mešanice je bila ločiti dve populaciji obalnih rakov po razmerjih dolžine čela in telesa. Karl Pearson je to težavo rešil leta 1894 z uporabo ujemanja trenutkov.

Skupna razširitev modelov mešanic je povezava latentnih spremenljivk, ki opredeljujejo identitete komponent mešanice, v Markovovo verigo, namesto da bi domnevali, da so neodvisne enako porazdeljene naključne spremenljivke. Nastali model se imenuje skriti Markov model in je eden najpogostejših zaporednih hierarhičnih modelov.

DBSCAN algoritem

Prostorsko združevanje aplikacij s hrupom na osnovi gostote (DBSCAN) je neparametrični algoritem za združevanje podatkov, ki izvira iz leta 1996. Optimiziran je za uporabo z bazami podatkov, ki lahko pospešijo poizvedbe o geometrijskih območjih z uporabo drevesa R * ali druge geometrijske indeksne strukture .

V bistvu grozdi DBSCAN bistvene točke ki imajo več kot nekaj najmanjšega števila sosedov na neki razdalji Epsilon, zavrže kot izstopajoče točke, ki nimajo sosedov znotraj Epsilona, in tej skupini doda točke, ki so znotraj Epsilona osrednje točke. DBSCAN je eden najpogostejših algoritmov združevanja v skupine in lahko najde poljubno oblikovane gruče.

Algoritem OPTICS

Urejanje točk za identifikacijo strukture gruč (OPTICS) je algoritem za iskanje grozdov na osnovi gostote v prostorskih podatkih. OPTICS je podoben DBSCAN-u, vendar obravnava primer različne gostote točk.

Različice idej v DBSCAN in OPTICS se lahko uporabljajo tudi za preprosto odkrivanje in odkrivanje in odstranjevanje hrupa.

Latentni spremenljivi modeli

Model latentne spremenljivke je statistični model, ki nabor opazovanih spremenljivk poveže z nizom latentnih (skritih) spremenljivk. Latentni spremenljivi modeli so uporabni za razkrivanje skritih struktur v zapletenih in visoko dimenzionalnih podatkih.

Analiza glavnih komponent

Analiza glavnih komponent (PCA) je statistični postopek, ki z uporabo pravokotne transformacije pretvori nabor opazovanj morebitno koreliranih numeričnih spremenljivk v nabor vrednosti linearno nekoreliranih spremenljivk, imenovanih glavne komponente. Karl Pearson je PCA izumil leta 1901. PCA je mogoče doseči z razgradnjo lastne vrednosti matrike kovariacije (ali korelacije) ali razgradnjo singularne vrednosti (SVD) matrike podatkov, običajno po koraku normalizacije začetnih podatkov.

Razgradnja singularne vrednosti

Razčlenitev singularne vrednosti (SVD) je faktorizacija realne ali kompleksne matrike. To je pogosta tehnika v linearni algebri in se pogosto izračuna z uporabo transformacij gospodinjstev. SVD je eden od načinov reševanja glavnih komponent. Čeprav je povsem mogoče SVD kodirati iz nič, obstajajo dobre izvedbe v vseh knjižnicah linearne algebre.

Metoda trenutkov

Metoda trenutkov za oceno parametrov populacije uporablja trenutke opazovanega vzorca podatkov (povprečje, varianca, poševnost in kurtoza). Metoda je precej preprosta, pogosto jo je mogoče izračunati ročno in običajno doseže globalno konvergenco. V primeru nizke statistike pa lahko metoda trenutkov včasih ustvari ocene, ki so zunaj prostora parametrov. Metoda trenutkov je enostaven način reševanja modelov mešanic (zgoraj).

Algoritmi maksimiranja pričakovanj

Algoritem pričakovanja in maksimizacije (EM) je iterativna metoda za iskanje ocen največje verjetnosti parametrov v modelih, ki so odvisni od neopaženih latentnih spremenljivk. Ponovitev EM se izmenjuje med izvajanjem koraka pričakovanja (E), ki ustvari funkcijo za pričakovanje verjetnosti dnevnika, ovrednotene z uporabo trenutne ocene parametrov, in koraka maksimizacije (M), ki izračuna parametre, ki maksimizirajo pričakovani log- verjetnost ugotovljena na koraku E.

EM se konvergira do maksimuma ali sedla, ni pa nujno do globalnega maksimuma. Možnost iskanja globalnega maksimuma lahko povečate s ponovitvijo EM postopka iz številnih naključnih začetnih ocen za parametre ali z uporabo metode trenutkov za določitev začetnih ocen.

EM, ki se uporablja za model Gaussove mešanice (zgoraj), se lahko uporablja za analizo grozdov.

Nenadzorovane nevronske mreže

Nevronske mreže so običajno usposobljene na označenih podatkih za razvrščanje ali regresijo, ki je po definiciji nadzorovano strojno učenje. Lahko se tudi usposobijo za neoznačene podatke z uporabo različnih nenadzorovanih shem.

Samodejni kodirniki

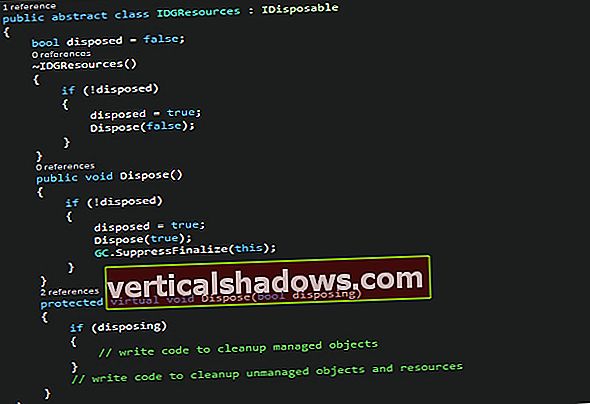

Avtokoderji so nevronske mreže, ki so usposobljene na njihovih vložkih. V bistvu je samodejni koder napajalno omrežje, ki deluje kot kodek in kodira svoj vhod iz vhodne plasti v eno ali več skritih plasti z nižjim številom nevronov in nato kodirano predstavitev dekodira v izhodno plast s topologijo kot vhod.

Med treningom samodejni kodirnik uporablja povratno širjenje, da zmanjša razliko med vhodom in izhodom. Avtokoderji so bili uporabljeni za zmanjšanje dimenzionalnosti, učenje funkcij, zmanjšanje hrupa, odkrivanje anomalij, obdelavo slik in za učenje generativnih modelov.

Mreže globokih prepričanj

Mreže globokih prepričanj (DBN) so skladi avtokoderjev ali omejenih Boltzmannovih strojev (RBN), ki se lahko naučijo rekonstruirati svoje vložke. Nato sloji delujejo kot detektorji lastnosti. RBN se običajno usposobijo s kontrastnimi divergencami.

DBN-ji so bili uporabljeni za ustvarjanje in prepoznavanje slik, video sekvenc in podatkov o zajemanju gibanja.

Generativne kontradiktorne mreže

Generativne kontradiktorne mreže (GAN) hkrati trenirajo dve mreži, generativni model, ki zajema distribucijo podatkov, in diskriminacijski model, ki ocenjuje verjetnost, da je vzorec izhajal iz podatkov usposabljanja. Vadba poskuša povečati verjetnost, da bi generator lahko zavedel diskriminator.

GAN lahko uporabimo za ustvarjanje fotografij namišljenih ljudi in izboljšanje astronomskih podob. GAN-i so bili uporabljeni tudi za povečanje tekstur starih video iger za uporabo v različicah iger z visoko ločljivostjo. Zunaj nenadzorovanega učenja se GAN uspešno uporabljajo za krepitev učenja igranja iger.

Zemljevid, ki se samoorganizira

Zemljevid za samoorganizacijo (SOM) definira urejeno preslikavo iz niza danih podatkovnih postavk v običajno, običajno dvodimenzionalno mrežo. Model je povezan z vsakim vozliščem mreže. Podatkovna postavka bo preslikana v vozlišče, katerega model je najbolj podoben podatkovnemu elementu, tj. Ima najmanjšo oddaljenost od podatkovnega elementa v neki metriki.

Obstajajo številni previdnostni ukrepi, ki jih morate sprejeti, da zagotovite stabilnost in dobro urejenost preslikav. Vse komercialne izvedbe ne upoštevajo vseh previdnostnih ukrepov.